Runway前腳剛發(fā)布Gen-3Alpha,Google后腳就跟了個(gè)王炸。

北京時(shí)間6月18日凌晨,Google Deepmind發(fā)布了視頻生成音頻(Video-to-Audio,V2A)技術(shù)的進(jìn)展,可以為視頻創(chuàng)建戲劇性的背景音樂(lè),逼真的音效,甚至是人物之間的對(duì)話。

V2A技術(shù)支持為AI生成視頻“配樂(lè)”,Google還特別強(qiáng)調(diào)了官網(wǎng)發(fā)布的Demo視頻都是由自家在五月份發(fā)布的生成視頻模型“Veo”和V2A技術(shù)合作打造。

有不少網(wǎng)友表示,這下終于可以給用Luma生成的meme視頻配上聲音了!

從Google Deepmind官網(wǎng)發(fā)布的Blog上看,V2A技術(shù)會(huì)采用視頻像素和文本提示來(lái)生成與底層視頻同步的音頻波形。

首先,V2A會(huì)對(duì)視頻和文本提示進(jìn)行編碼,并通過(guò)擴(kuò)散模型迭代運(yùn)行,將隨機(jī)噪聲細(xì)化為與視頻和所提供的文本提示相匹配的真實(shí)音頻,最后再對(duì)音頻進(jìn)行解碼并與視頻數(shù)據(jù)相結(jié)合。

X網(wǎng)友紛紛表示太贊了,但就是有一個(gè)小小小小的問(wèn)題,和同樣是凌晨發(fā)布的Runway的視頻生成模型Gen-3Alpha一樣,這又是一個(gè)大家都用不上的超贊模型,到底啥時(shí)候開(kāi)源讓咱們?cè)囋囁?

先不急,我們先嘗嘗官方發(fā)布的Demo咸淡!

Google認(rèn)為,AI視頻生成模型飛速發(fā)展,但市面上的大多數(shù)模型,不管是Sora、Luma,還是剛剛發(fā)布的Gen-3Alpha,都只能生成無(wú)聲視頻。

而Google所研發(fā)的V2A技術(shù)能夠使AI視頻進(jìn)入“有聲時(shí)代”,進(jìn)一步推動(dòng)AI在視聽(tīng)方面的完善與發(fā)展。

從Demo視頻來(lái)看,其效果真的挺絲滑的,怪不得Google“夸下海口”!

比如這個(gè),畫(huà)面中一個(gè)人從前走到后,可以聽(tīng)到令人不安的背景音樂(lè)和嘎吱嘎吱的腳步聲。

【提示:電影、驚悚片、恐怖片、音樂(lè)、緊張感、氛圍、混凝土上的腳步聲。Prompt for audio: Cinematic, thriller, horror film, music, tension, ambience, footsteps on concrete】

諸如此類(lèi)的視頻配樂(lè)還有小恐龍破殼的聲音、打鼓的音樂(lè)聲、車(chē)流聲等等。

【提示:可愛(ài)的小恐龍鳴叫、叢林氛圍、雞蛋破裂。Prompt for audio: Cute baby dinosaur chirps, jungle ambience, egg cracking】

【提示:音樂(lè)會(huì)舞臺(tái)上的鼓手被閃爍的燈光和歡呼的人群包圍。Prompt for audio: A drummer on a stage at a concert surrounded by flashing lights and a cheering crowd】

【提示:汽車(chē)打滑、汽車(chē)發(fā)動(dòng)機(jī)節(jié)流、天使般的電子音樂(lè)。Prompt for audio: cars skidding, car engine throttling, angelic electronic music】

Google還強(qiáng)調(diào),V2A技術(shù)之所以能夠在卷得要命的AI視頻圈“脫穎而出”,是因?yàn)樵摷夹g(shù)可以理解原始像素,因而哪怕不輸入文本提示,只要用戶提供視頻,該技術(shù)也可以為其“配樂(lè)”。

例如,下面視頻中的吉他聲和自行車(chē)聲是在沒(méi)有任何提示的情況下合成的。

V2A技術(shù)也可以生成人物對(duì)話,比如下面視頻中角色所說(shuō)的臺(tái)詞,“這只火雞看起來(lái)棒極了,我好餓啊(this turkey looks amazing, I'm so hungry)”。

不過(guò)從視頻中看,人物唇形與臺(tái)詞并不完全匹配,因?yàn)?strong>視頻模型不會(huì)生成與轉(zhuǎn)錄文本相匹配的嘴部動(dòng)作,Google也承認(rèn)這一部分仍在研究完善當(dāng)中。

此外,V2A技術(shù)還支持為視頻輸入生成無(wú)限數(shù)量的音軌,用戶可以選擇定義“正提示”來(lái)引導(dǎo)生成所需的聲音,或定義“負(fù)提示”來(lái)引導(dǎo)遠(yuǎn)離不需要的聲音。

這種靈活性使用戶能夠更好地控制V2A的音頻輸出,從而可以快速嘗試不同的音頻輸出,并選擇最佳匹配。

下面三個(gè)視頻是Google放出的Demo,我們猜測(cè)Google是想說(shuō)明用戶可以用不同的文本提示來(lái)定向地修改配樂(lè)中的一些要素,不過(guò)好像不太明顯

【提示:一艘宇宙飛船在浩瀚的太空中疾馳,星星從它身邊飛過(guò),速度很快,科幻感。Prompt for audio: A spaceship hurtles through the vastness of space, stars streaking past it, high speed, Sci-fi】

【提示:空靈的大提琴氛圍。Prompt for audio: Ethereal cello atmosphere】

【提示:一艘宇宙飛船在浩瀚的太空中疾馳,星星從它身邊飛過(guò),速度很快,科幻效果。Prompt for audio: A spaceship hurtles through the vastness of space, stars streaking past it, high speed, Sci-fi】

雖然該技術(shù)還未開(kāi)源,但從現(xiàn)有的Demo來(lái)看,待其開(kāi)源之時(shí),必將又掀起AI視頻圈一陣大風(fēng)浪。

屆時(shí)我們估計(jì)能看到AI圈“大混戰(zhàn)”——Runway的Gen-3Alpha剛生成一個(gè)視頻,隔壁V2A就給它把音樂(lè)配好了;Meme變視頻還沒(méi)玩夠呢,用戶們已經(jīng)等不及給它配上聲音了。

AI視頻圈,到底要“卷”成什么樣?!

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請(qǐng)謹(jǐn)慎對(duì)待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國(guó)際市場(chǎng)上廣受好評(píng),目前站內(nèi)累計(jì)模型數(shù)超過(guò)80萬(wàn)個(gè),涵蓋寫(xiě)實(shí)、二次元、插畫(huà)、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類(lèi)型應(yīng)用場(chǎng)景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

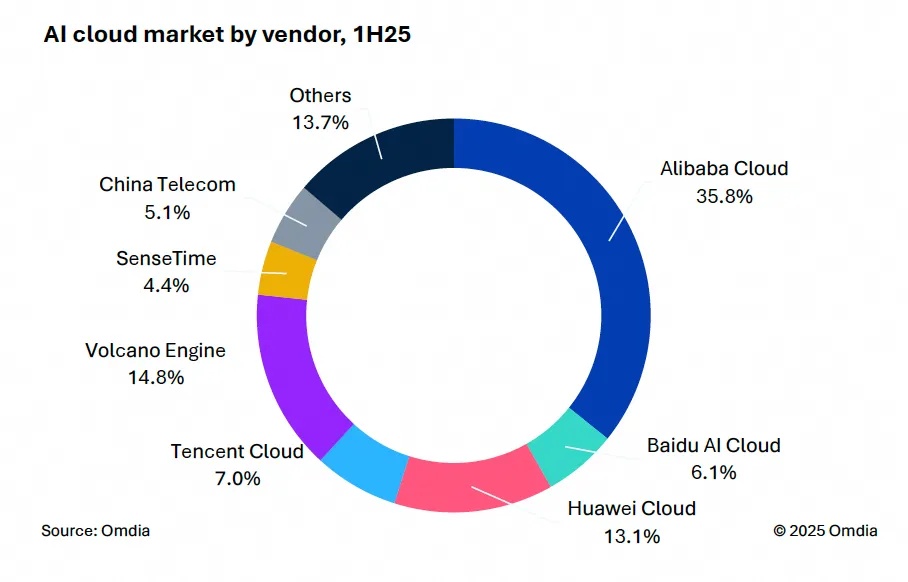

9月9日,國(guó)際權(quán)威市場(chǎng)調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國(guó)AI云市場(chǎng),1H25》報(bào)告。中國(guó)AI云市場(chǎng)阿里云占比8%位列第一。

9月24日,華為坤靈召開(kāi)“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會(huì)。

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場(chǎng)季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場(chǎng)出貨1,2萬(wàn)臺(tái),同比增長(zhǎng)33%,顯示出品類(lèi)強(qiáng)勁的市場(chǎng)需求。