今天凌晨3點(diǎn),全球最大開源平臺(tái)之一huggingface聯(lián)合創(chuàng)始人兼首席執(zhí)行官Clement Delangue發(fā)布了最新數(shù)據(jù):

中國(guó)開源大模型DeepSeek-R1在150萬模型中,成為該平臺(tái)最受歡迎的開源大模型,點(diǎn)贊超過1萬。

前不久,Clement還特意發(fā)文恭喜DeepSeek-R1的下載量超過1000萬次,同樣創(chuàng)造了huggingface平臺(tái)有史以來最受歡迎的模型。

看來,Clement也吃到DeepSeek的紅利了,對(duì)它是真愛啊連續(xù)表?yè)P(yáng)。

值得一提的是,R1僅用了幾周的時(shí)間就超過了類ChatGPT開源鼻祖Meta發(fā)布的Llama系列,國(guó)內(nèi)的開源大模型領(lǐng)頭羊Qwen系列,以及微軟開源的Phi系列,谷歌開源的Gemma系列。

就連開源文生圖模型的大黑馬FLUX.1,以及該領(lǐng)域的領(lǐng)導(dǎo)者Stable-Diffusion系列全都沒打過R1,這第一拿的實(shí)至名歸,踩著眾多開源高手上去的。

有網(wǎng)友表示,R1的開源徹底改變了AI領(lǐng)域。

本周,Deepseek表示將推出大量新功能,伙計(jì)你可來活了!

本周我們將獲得更多的開源驚喜!

巨大的功勞歸于 Deepseek,他們讓開源再次出色。他們徹底改變了游戲規(guī)則,并讓所有閉源模型都感到壓力。

即使像 Perplexity、Azure、AWS這樣的云平臺(tái),也更傾向于使用 Deepseek,而不是他們自己的投資Sonar、OpenAI 或Anthropic 的模型。

DeepSeek-R1簡(jiǎn)單介紹

其實(shí)DeepSeek在開發(fā)R1之前,先開發(fā)的是純強(qiáng)化學(xué)習(xí)版本R1-Zero,不依賴傳統(tǒng)的監(jiān)督微調(diào),采用了GRPO算法。雖然訓(xùn)練出來性能不錯(cuò),但可讀性差和語(yǔ)言混合等都很差。

所以,在R1-Zero基礎(chǔ)之上訓(xùn)練了R1模型,一共包含4個(gè)訓(xùn)練階段。

冷啟動(dòng)訓(xùn)練階段:與R1-Zero 不同,為了避免強(qiáng)化學(xué)習(xí)訓(xùn)練初期從基礎(chǔ)模型開始的不穩(wěn)定冷啟動(dòng)階段, R1構(gòu)建并收集了少量長(zhǎng)思維鏈數(shù)據(jù),對(duì) DeepSeek-V3-Base 模型進(jìn)行微調(diào),作為初始的強(qiáng)化學(xué)習(xí)參與者。

在收集數(shù)據(jù)時(shí),研究團(tuán)隊(duì)探索了多種方法,例如,使用帶有長(zhǎng)思維鏈的少樣本提示作為示例、直接促使模型生成帶有反思和驗(yàn)證的詳細(xì)答案、收集R1-Zero以可讀格式輸出的結(jié)果并通過人工標(biāo)注后處理優(yōu)化等,收集了數(shù)千條冷啟動(dòng)數(shù)據(jù)來微調(diào)模型。

推理導(dǎo)向的強(qiáng)化學(xué)習(xí)階段:主要聚焦于提升模型在編碼、數(shù)學(xué)、科學(xué)和邏輯推理等推理密集型任務(wù)中的能力,這些任務(wù)通常具有明確的問題和解決方案。

在訓(xùn)練過程中,發(fā)現(xiàn)思維鏈存在語(yǔ)言混合問題,尤其是當(dāng)強(qiáng)化學(xué)習(xí)提示涉及多種語(yǔ)言時(shí)。為緩解這一問題,引入了語(yǔ)言一致性獎(jiǎng)勵(lì),通過計(jì)算思維鏈中目標(biāo)語(yǔ)言單詞的比例來衡量。雖然消融實(shí)驗(yàn)表明這種調(diào)整會(huì)導(dǎo)致模型性能略有下降,但它符合人類偏好,提高了可讀性。

最后,將推理任務(wù)的準(zhǔn)確性和語(yǔ)言一致性獎(jiǎng)勵(lì)直接相加,形成最終獎(jiǎng)勵(lì),并對(duì)微調(diào)后的模型進(jìn)行強(qiáng)化學(xué)習(xí)訓(xùn)練,直至推理任務(wù)收斂。

拒絕采樣和監(jiān)督微調(diào)階段:當(dāng)推理導(dǎo)向的強(qiáng)化學(xué)習(xí)收斂后,利用得到的檢查點(diǎn)收集監(jiān)督微調(diào)數(shù)據(jù),用于后續(xù)輪次的訓(xùn)練。與初始冷啟動(dòng)數(shù)據(jù)主要關(guān)注推理不同,

該階段的數(shù)據(jù)融合了其他領(lǐng)域的數(shù)據(jù),以提升模型在寫作、角色扮演和其他通用任務(wù)中的能力。在推理數(shù)據(jù)方面,精心策劃推理提示,并通過對(duì)上述強(qiáng)化學(xué)習(xí)訓(xùn)練的檢查點(diǎn)進(jìn)行拒絕采樣生成推理軌跡。

全場(chǎng)景強(qiáng)化學(xué)習(xí)階段:為了使R1模型更好地符合人類偏好,實(shí)施了二次強(qiáng)化學(xué)習(xí)階段。該階段主要提高模型的有用性和無害性,同時(shí)進(jìn)一步優(yōu)化其推理能力。

通過結(jié)合獎(jiǎng)勵(lì)信號(hào)和多樣化的提示分布來訓(xùn)練模型。對(duì)于推理數(shù)據(jù),遵循R1-Zero 中使用的方法,利用基于規(guī)則的獎(jiǎng)勵(lì)在數(shù)學(xué)、代碼和邏輯推理領(lǐng)域引導(dǎo)學(xué)習(xí)過程;

對(duì)于通用數(shù)據(jù),則采用獎(jiǎng)勵(lì)模型來捕捉復(fù)雜和微妙場(chǎng)景中的人類偏好。基于 DeepSeek-V3的流程,采用類似的偏好對(duì)和訓(xùn)練提示分布。在評(píng)估有用性時(shí),僅關(guān)注最終總結(jié),確保評(píng)估重點(diǎn)在于響應(yīng)對(duì)用戶的實(shí)用性和相關(guān)性,同時(shí)盡量減少對(duì)底層推理過程的干擾;

在評(píng)估無害性時(shí),評(píng)估模型的整個(gè)響應(yīng),包括推理過程和總結(jié),以識(shí)別和減輕生成過程中可能出現(xiàn)的任何潛在風(fēng)險(xiǎn)、偏差或有害內(nèi)容。

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請(qǐng)謹(jǐn)慎對(duì)待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國(guó)際市場(chǎng)上廣受好評(píng),目前站內(nèi)累計(jì)模型數(shù)超過80萬個(gè),涵蓋寫實(shí)、二次元、插畫、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類型應(yīng)用場(chǎng)景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

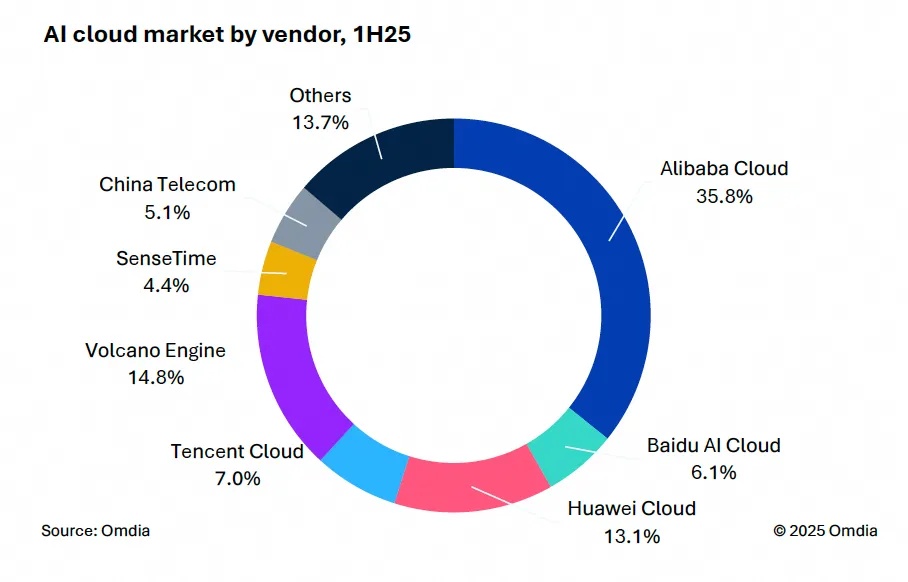

9月9日,國(guó)際權(quán)威市場(chǎng)調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國(guó)AI云市場(chǎng),1H25》報(bào)告。中國(guó)AI云市場(chǎng)阿里云占比8%位列第一。

9月24日,華為坤靈召開“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會(huì)。

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場(chǎng)季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場(chǎng)出貨1,2萬臺(tái),同比增長(zhǎng)33%,顯示出品類強(qiáng)勁的市場(chǎng)需求。