從2017年全面向技術(shù)轉(zhuǎn)型至今,京東不僅用技術(shù)重塑了零售的生態(tài),更是突破了零售的邊界,將技術(shù)全面拓展至數(shù)字科技、物流、健康等眾多領(lǐng)域。然而,由于與零售密切相關(guān),大多數(shù)消費(fèi)者僅在購物、物流等環(huán)節(jié)體驗(yàn)到京東的技術(shù)進(jìn)步。其實(shí),在這些常見場景之外,京東的語音技術(shù)也已經(jīng)擁有成熟的應(yīng)用領(lǐng)域,例如京東智能客服和京東物流大件外呼,語音技術(shù)的相關(guān)研究也取得了重大進(jìn)展,并獲得國際認(rèn)可。

備受全球關(guān)注的第21屆國際語音通訊會議INTERSPEECH2020在上海召開。作為國際語音通訊協(xié)會(International Speech Communication Association,ISCA)主辦的頂級國際會議,INTERSPEECH是國際公認(rèn)的語音領(lǐng)域兩大頂會之一。此次會議共接收有效論文投稿2140篇,錄取1022篇,覆蓋語音、信號處理、口語語言處理等多個(gè)方面。京東AI研究院共計(jì)4篇論文被收錄其中,包括獨(dú)立發(fā)表的3篇論文及與德克薩斯大學(xué)達(dá)拉斯分校聯(lián)合發(fā)表的1篇論文,內(nèi)容涵蓋語音識別、語音增強(qiáng)、聲紋識別、語音合成等多個(gè)技術(shù)方向的創(chuàng)新突破。

聲源定位、增強(qiáng)和辨識是涉及到人機(jī)交互、語音增強(qiáng)、數(shù)字信號處理等的重要技術(shù),在智能家居、智能安防等領(lǐng)域具有重要的應(yīng)用價(jià)值。而在實(shí)際應(yīng)用中,噪聲與混響的存在常常會導(dǎo)致算法性能下降,尤其在室內(nèi)環(huán)境中,混響、多聲源混疊等干擾尤為明顯。如何有效利用麥克風(fēng)陣列及傳統(tǒng)聲學(xué)處理方法,和深度神經(jīng)網(wǎng)絡(luò)結(jié)合,提高復(fù)雜環(huán)境下的聲源定位、增強(qiáng)和辨識任務(wù)的性能,具有重要的科學(xué)意義和應(yīng)用價(jià)值。

針對聲源定位和辨識問題,京東AI研究院在《Sound Event Localization and Detection Based on Multiple DOA Beamforming and Multi-task Learning》論文中提出了一種基于多方位波束形成和多任務(wù)學(xué)習(xí)的聲音事件檢測和定位方法,主要特點(diǎn)為利用傳統(tǒng)聲學(xué)信號處理為神經(jīng)網(wǎng)絡(luò)提供更為豐富的信息。具體而言,通過指向不同預(yù)定方位的固定波束形成,可提取各個(gè)方位的聲源信號,并抑制該方位之外的干擾信號。該方法無需預(yù)先進(jìn)行聲源定位或掩蔽估計(jì),即可獲得差異化、多樣化的聲學(xué)空間表示。根據(jù)在DCASE2019聲音事件檢測和定位數(shù)據(jù)集上進(jìn)行的評估,顯示這個(gè)算法取得了最好的綜合性能。

為了降低混響以增強(qiáng)語音,京東AI研究院與國際語音通訊協(xié)會主席John Hansen研究組進(jìn)行了合作,和德克薩斯大學(xué)達(dá)拉斯分校共同發(fā)表了《SkipConvNet: Skip Convolutional Neural Network for Speech Dereverberation using Optimally Smoothed Spectral Mapping》,提出利用全卷積神經(jīng)網(wǎng)絡(luò)提升語音降混響,并提高語音識別和說話人識別的性能。基于“SkipConvNet”的降混響算法,用多個(gè)卷積網(wǎng)絡(luò)替換UNet的每個(gè)跳層連接,為decoder供更為直觀的信息表示。論文還提出了基于最優(yōu)平滑功率譜估計(jì)的預(yù)處理步驟,以提高對復(fù)雜條件下語音功率譜的表達(dá)能力。實(shí)驗(yàn)結(jié)果表明,這一方法在語音客觀質(zhì)量評估上顯著優(yōu)于基線系統(tǒng),并明顯提升混響條件下的語音識別/說話人識別的評估指標(biāo)。

語音識別及聲學(xué)前端處理的技術(shù)提升為語音交互成為人機(jī)交互的重要入口提供了技術(shù)支撐。但只識別指令內(nèi)容是不夠的,真正的智能交互產(chǎn)生的基礎(chǔ)是機(jī)器能識別、區(qū)分說話人的身份,這就需要依托聲紋識別技術(shù)。

京東AI在《The JD AI Speaker Verification System for the FFSVC 2020 Challenge》一文中,基于FFSVC2020比賽提供的1100小時(shí)共計(jì)120個(gè)說話人的數(shù)據(jù),京東提出了面向遠(yuǎn)場說話人識別的多套數(shù)據(jù)增強(qiáng)方案。首先,通過波束形成、通道交換和降混響等技術(shù),我們將遠(yuǎn)場數(shù)據(jù)變換到近場;其次,通過估計(jì)FFSVC2020近場到遠(yuǎn)場數(shù)據(jù)的房間沖激響應(yīng)以及仿真生成大量的房間沖激響應(yīng),我們增加卷積噪聲以將近場數(shù)據(jù)變換到遠(yuǎn)場;最后,基于錄制的大量的環(huán)境噪聲,在近場數(shù)據(jù)上進(jìn)一步疊加了加性噪聲。本文詳細(xì)測試了上述數(shù)據(jù)增強(qiáng)方案的性能,并通過實(shí)驗(yàn)結(jié)果驗(yàn)證系統(tǒng)性能可以得到大幅提升。

除了在語音識別技術(shù)能力上進(jìn)行深入研究外,京東還在語音合成的推理速度上進(jìn)行了更多探索。在《Efficient WaveGlow: An Improved WaveGlow Vocoder with Enhanced Speed》一文中,京東提出了Efficient WaveGlow框架。和傳統(tǒng)的WaveGlow框架一樣,Efficient WaveGlow采用歸一化流作為網(wǎng)絡(luò)框架,每一個(gè)流操作由一個(gè)affine coupling layer和可逆的1x1卷積層構(gòu)成。通過對Efficient WaveGlow進(jìn)行改進(jìn),京東實(shí)現(xiàn)了在沒有明顯的聲音質(zhì)量下降的情況下,實(shí)現(xiàn)CPU上推理速度6倍的提升以及P40顯卡上推理速度5倍的提升。

京東語音技術(shù)能獲得國際認(rèn)可,與其對技術(shù)研發(fā)的重視密不可分。這些技術(shù)將進(jìn)一步增強(qiáng)京東的智能語音能力。目前,京東智能語音技術(shù)已經(jīng)在智能外呼機(jī)器人、客服語音機(jī)器人等電話交互場景中實(shí)現(xiàn)成熟應(yīng)用。在技術(shù)的加持下,京東不僅會夯實(shí)在零售生態(tài)的實(shí)力與地位,還可以通過技術(shù)賦能金融、醫(yī)療、教育、健康等行業(yè),為更多用戶提供便利服務(wù)。

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請謹(jǐn)慎對待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國際市場上廣受好評,目前站內(nèi)累計(jì)模型數(shù)超過80萬個(gè),涵蓋寫實(shí)、二次元、插畫、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類型應(yīng)用場景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

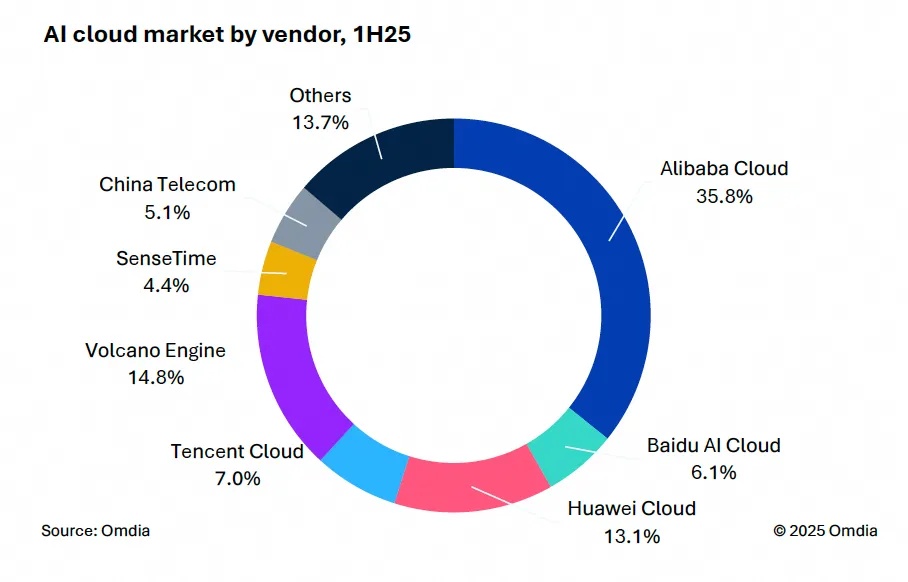

9月9日,國際權(quán)威市場調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國AI云市場,1H25》報(bào)告。中國AI云市場阿里云占比8%位列第一。

9月24日,華為坤靈召開“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會。

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場出貨1,2萬臺,同比增長33%,顯示出品類強(qiáng)勁的市場需求。