UC伯克利的研究人員提出了一項(xiàng)名為RingAttention的新方法,以解決深度學(xué)習(xí)模型中內(nèi)存需求的挑戰(zhàn)。在最新的研究中,研究人員探討了Transformer模型在處理長序列時(shí)面臨的問題,特別是由于自注意力機(jī)制引發(fā)的內(nèi)存需求。這一問題已經(jīng)成為了在人工智能領(lǐng)域中提高模型性能的一個(gè)重要挑戰(zhàn)。

Transformer模型是一種在自然語言處理等領(lǐng)域取得了重大突破的深度學(xué)習(xí)架構(gòu)。它基于自注意力機(jī)制,可以在進(jìn)行預(yù)測時(shí)權(quán)衡輸入序列的不同部分的重要性。然而,隨著輸入序列長度的增加,內(nèi)存需求呈二次增長,這導(dǎo)致了在處理長序列時(shí)的挑戰(zhàn)。

UC伯克利的研究人員提出了RingAttention方法,通過將自注意力和前饋網(wǎng)絡(luò)計(jì)算分塊進(jìn)行,可以將輸入序列分布到多個(gè)設(shè)備上,從而實(shí)現(xiàn)內(nèi)存高效。這一方法的關(guān)鍵思想是將計(jì)算塊塊塊地分布在多個(gè)設(shè)備上,同時(shí)保持內(nèi)存消耗與塊大小成比例。這意味著每個(gè)設(shè)備的內(nèi)存需求與原始輸入序列長度無關(guān),從而消除了設(shè)備內(nèi)存的限制。

研究人員的實(shí)驗(yàn)證明,RingAttention可以將Transformer模型的內(nèi)存需求降低,使其能夠訓(xùn)練比以前的內(nèi)存高效方法長500倍以上的序列,而不需要對注意力機(jī)制進(jìn)行近似。此外,RingAttention還允許處理長度超過1億的序列,為處理大規(guī)模數(shù)據(jù)提供了可能性。

盡管這項(xiàng)研究僅涉及方法的有效性評(píng)估,而未進(jìn)行大規(guī)模訓(xùn)練模型,但這一方法的性能取決于設(shè)備數(shù)量,因此還需要進(jìn)一步的優(yōu)化。研究人員表示,他們將來計(jì)劃在最大序列長度和最大計(jì)算性能方面進(jìn)行更多研究,這將為大型視頻-音頻-語言模型、利用擴(kuò)展反饋和試驗(yàn)錯(cuò)誤學(xué)習(xí)、代碼生成和理解科學(xué)數(shù)據(jù)等領(lǐng)域提供激動(dòng)人心的機(jī)會(huì)。

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請謹(jǐn)慎對待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國際市場上廣受好評(píng),目前站內(nèi)累計(jì)模型數(shù)超過80萬個(gè),涵蓋寫實(shí)、二次元、插畫、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類型應(yīng)用場景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

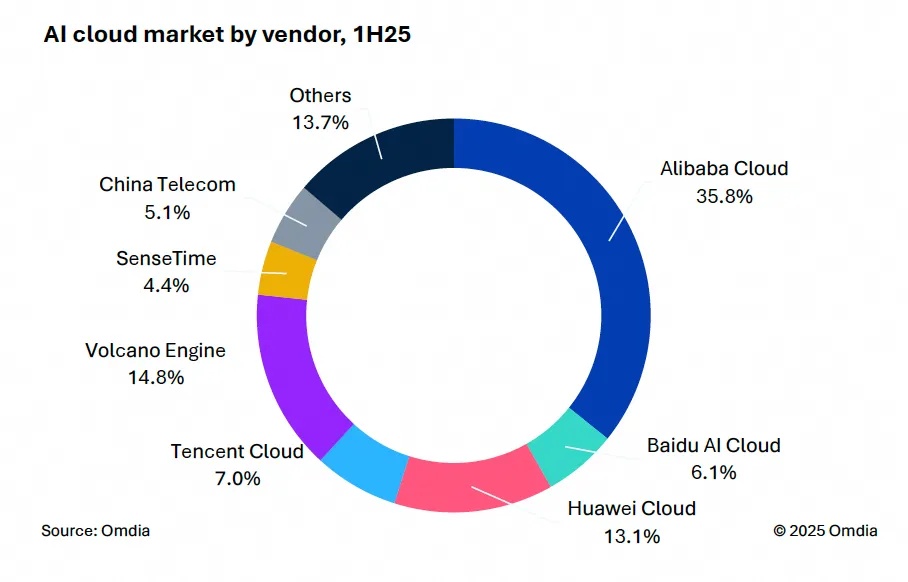

9月9日,國際權(quán)威市場調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國AI云市場,1H25》報(bào)告。中國AI云市場阿里云占比8%位列第一。

9月24日,華為坤靈召開“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會(huì)。

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場出貨1,2萬臺(tái),同比增長33%,顯示出品類強(qiáng)勁的市場需求。