小紅書近日宣布開源其首個大規(guī)模模型 ——dots.llm1,該模型具有1420億個參數(shù),是一種專家混合模型(MoE)。在推理過程中僅激活140億參數(shù),這種結(jié)構(gòu)不僅保持了高性能,還大幅降低了訓(xùn)練和推理的成本。

dots.llm1使用了11.2萬億個非合成的高質(zhì)量訓(xùn)練數(shù)據(jù),該模型在中文測試中的表現(xiàn)優(yōu)異,平均得分91.3,超越了多款競爭對手。

在技術(shù)架構(gòu)方面,dots.llm1采用了單向解碼器 Transformer 結(jié)構(gòu),并將傳統(tǒng)前饋網(wǎng)絡(luò)替換為 MoE。與傳統(tǒng)模型不同,MoE 將多個專家網(wǎng)絡(luò)分開,每個專家網(wǎng)絡(luò)專注于輸入數(shù)據(jù)的不同特征,從而在推理時只激活一小部分網(wǎng)絡(luò)進(jìn)行計算,大幅度節(jié)省了算力需求。

dots.llm1包含128個路由專家和2個共享專家。每個專家都是一個具有兩層前饋結(jié)構(gòu)的網(wǎng)絡(luò),使用 SwiGLU 激活函數(shù)以捕捉數(shù)據(jù)中的復(fù)雜關(guān)系。在處理輸入標(biāo)記時,模型會動態(tài)選擇出6個最相關(guān)的專家和2個共享專家進(jìn)行運(yùn)算。

此外,dots.llm1在訓(xùn)練過程中還引入了改進(jìn)的 RMSNorm 歸一化操作,以穩(wěn)定模型性能和輸出。在 MoE 模塊中,負(fù)載平衡策略的引入確保了所有專家網(wǎng)絡(luò)的使用均衡,從而避免了過度依賴某些專家的問題。

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請謹(jǐn)慎對待。投資者據(jù)此操作,風(fēng)險自擔(dān)。

海報生成中...

海藝AI的模型系統(tǒng)在國際市場上廣受好評,目前站內(nèi)累計模型數(shù)超過80萬個,涵蓋寫實、二次元、插畫、設(shè)計、攝影、風(fēng)格化圖像等多類型應(yīng)用場景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

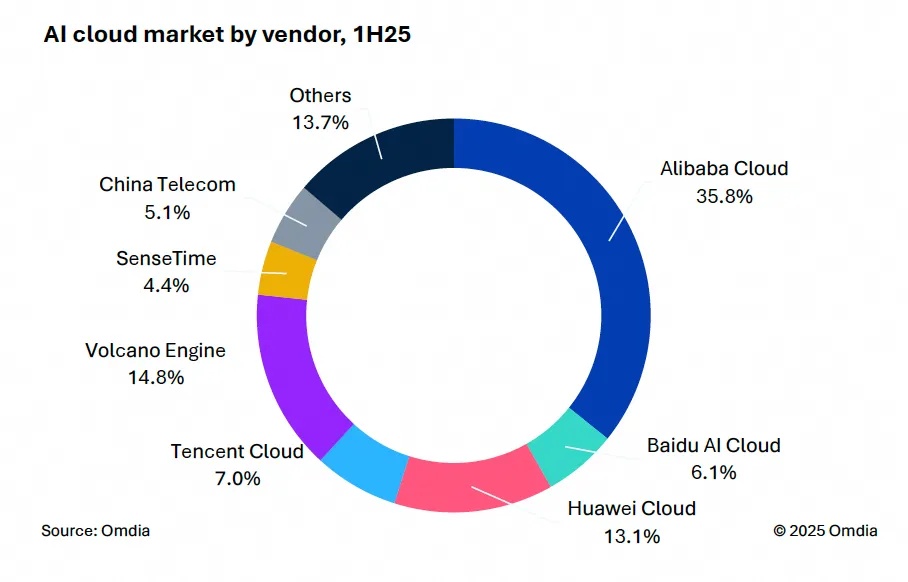

9月9日,國際權(quán)威市場調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國AI云市場,1H25》報告。中國AI云市場阿里云占比8%位列第一。

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場出貨1,2萬臺,同比增長33%,顯示出品類強(qiáng)勁的市場需求。